SwiGLU 激活函数

6.16

SwiGLU 激活函数长什么样?

Swish-Gated Linear Unit(SwiGLU)的表达式如下:

其中 A 和 B 是线性变换后的结果,

或者,可以写成另外一种形式:

其中

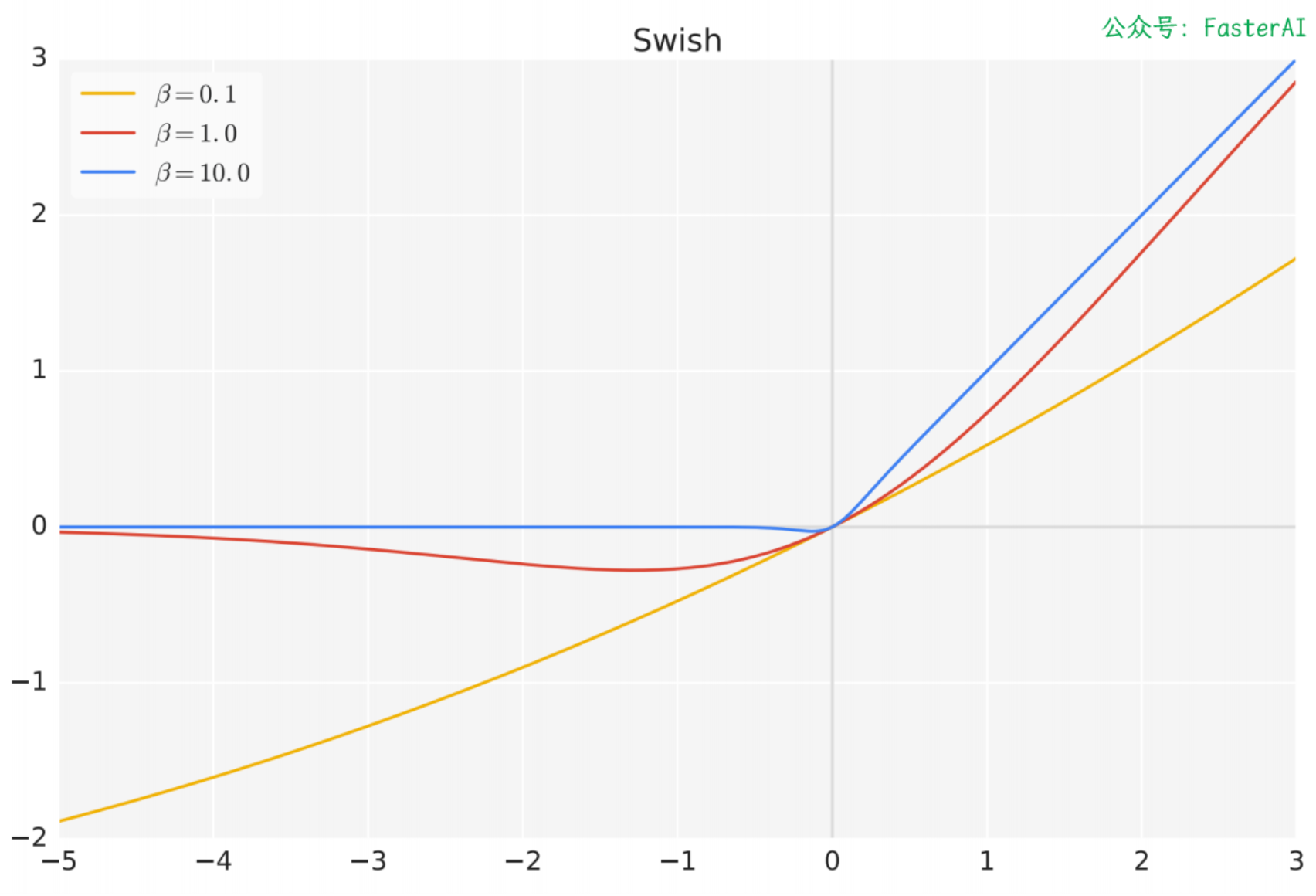

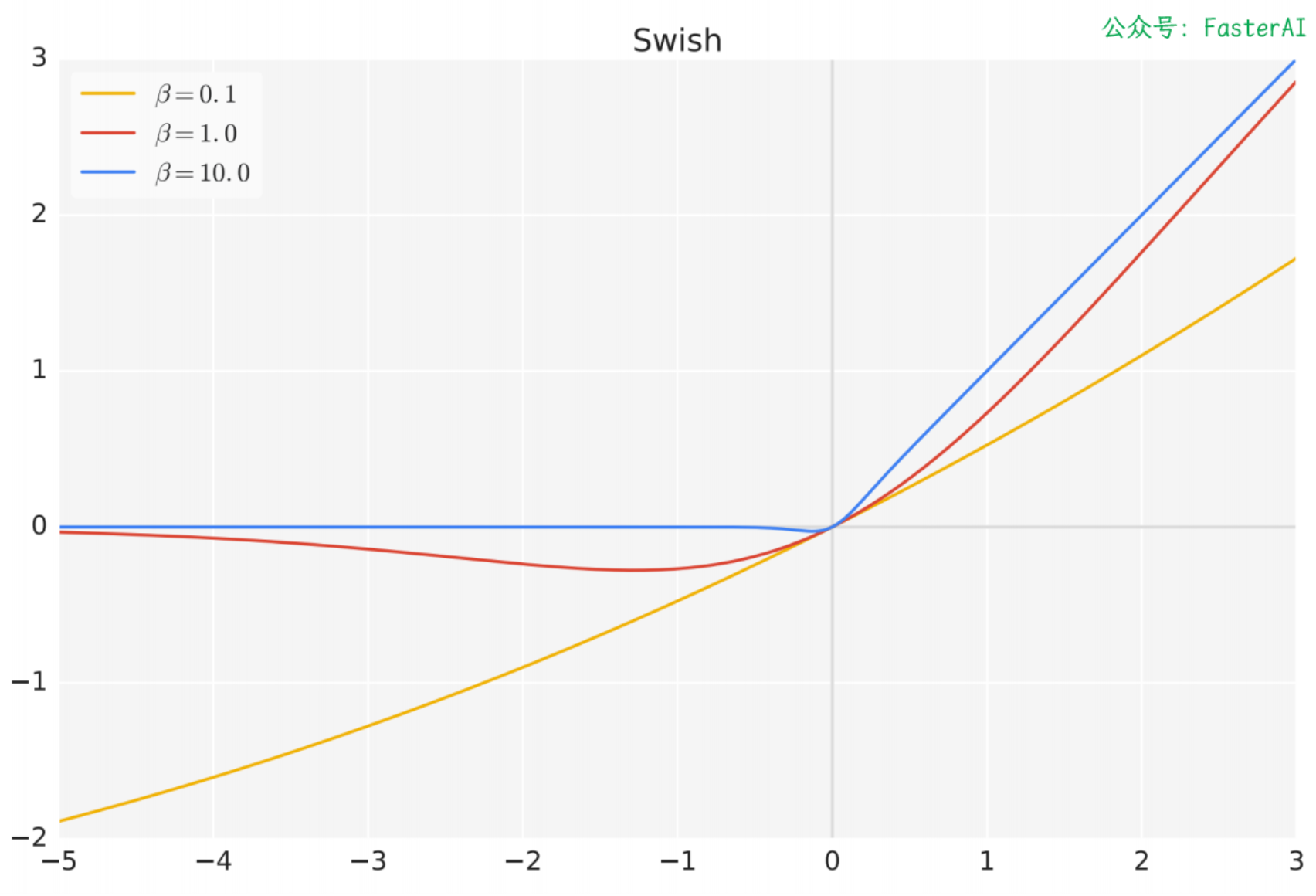

Swish 函数长什么样?

Swish 比 ReLU 激活函数更好,因为它在 0 附近提供了更平滑的转换。

Swish 激活函数在参数 β 不同取值下的形状:

mally的技术笔记

mally的技术笔记6.16

Swish-Gated Linear Unit(SwiGLU)的表达式如下:

其中 A 和 B 是线性变换后的结果,

或者,可以写成另外一种形式:

其中

Swish 比 ReLU 激活函数更好,因为它在 0 附近提供了更平滑的转换。

Swish 激活函数在参数 β 不同取值下的形状: